Stable diffusionの画質が悪い(クオリティが低い)時の対処法を紹介

AIによる画像生成と言えば、Stable Diffusionというアプリは定番中の定番でしょう。

しかし、最近Stable diffusionで生成した画像の画質が悪い、ぼやける、ノイズが多いと感じた人が多いようです。

せっかく生成した画像なのに、画質がぼやけたり、色がおかしかったりすると、なんとも使い勝手が悪くて、悔しい気持ちになりますね。

そこで本記事では、Stable Diffusionで生成した画像の画質が悪いときに考えられる対処法を紹介します。生成した画像やイラストの画質が悪くなったときの参考にしてください。

-

Stable diffusionで生成した画像の画質向上:Aiarty Image Enhancer

Stable diffusionで生成した画像の画質向上:Aiarty Image Enhancer対応画像形式:JPEG、JPEG2000、PNG、TIFF、Bitmap、RAW、SRWなど

特徴:最大32Kへの高画質化・拡大;解像度維持での鮮明化・ディテール強化;AI補正(色補正、ノイズ除去、ぼかし除去、顔レタッチ、消しゴムマジックなど);超高速処理(DirectML/TensorRT高速化)

(1)Stable Diffusionとは

Stable Diffusion(ステーブルディフュージョン)とは、22年8月にオープンソース形式で公開した画像生成AIです。

英スタートアップのStability AI社が開発したが、全世界にソースコードが無償公開されたことで多くの登録ユーザーを抱えています。

Stable Diffusionでは、システムに搭載された「潜在拡散モデル」というアルゴリズムによって画像が生成されています。

ユーザーは生成したい画像のイメージ(例えば、アマゾンのジャングル、高層ビルが建ち並ぶ都会、など)を単語で区切って入力することで、簡単にリアルな画像からイラスト風の画像まで作れます。

このような単語は「プロンプト(prompt)」と呼ばれて、画像生成の大部分が「プロンプト」に依存しています。実際にやってみたら、「英文作成が得意なユーザー」はより正確で高品質な画像を生み出せるということがわかります。

Stable Diffusionは、人物の生成が得意で、特に顔の表情や髪の質感などのクオリティが高く、多くのプロンプトが揃っています。さらには商用利用することも可能です。

この記事では、Stable Diffusion Web UIを日本語化する方法、プロンプトの書き方、Stable Diffusionで画像生成する方法など、Stable Diffusionの使い方について、初心者にもわかりやすく解説していきます。Stable Diffusionの使い方に関して不安や悩みを抱えている入門者はぜひ参考にしてみてください。

(2)Stable Diffusionの画質が悪い時の対処法(高画質化)

上述の通り、Stable Diffusionはイメージ通りの画像を効率よく生成できることから高く評価され、多くのユーザーに利用されています。

その一方、Stable Diffusionで生成した画像の「画質が悪い」「ぼやける」「ノイズが多い」といった声もよく聞けます。

実際には、Stable Diffusionの画質が悪くなる原因の多くはソフト自体の不具合ではなく、設定ミスや使用環境によるものです。適切な設定や対処法を知っていれば、画質は大きく改善できます。

ここからは、Stable Diffusionで生成した画像の画質が悪い・ぼやける・ノイズが多いと感じた場合に役立つ対処法を分かりやすくまとめて紹介します。

1. 専門のAIアップスケーリングツールを使う

現在のところ、画像を簡単に高画質化できるAIアップスケーリングツールは多数存在しています。

これらのツールは、機械学習やディープラーニングの技術を活用して、画像の解像度を向上させたり、鮮明度やディテールを改善したりすることが可能です。せっかく生成した画像の画質が悪くてなって困ったとき、AIアップスケーリングツールを活用しましょう。

代表的なツールとしては、Topazの「Gigapixel AI」、Digiartyの「Aiarty Image Enhancer」、またはAdobeの「Photoshop」などがあります。それぞれのツールには独自のアルゴリズムや機能があり、利用目的や使用状況に応じて選択できます。

今回は、AIで生成した画像の画質改善に特化したツールの中でも、操作の簡単さと仕上がりの自然さに定評がある「Aiarty Image Enhancer」を特におすすめです。

- おすすめポイント

- 🟊 高精度なAI高画質化機能を搭載し、ディテールをできるだけ保ったまま自然に解像度を向上できる;

- 🟊 操作はシンプルで直感的。細かい設定をしなくても、クリックするだけで誰でも簡単に高画質化が可能;

- 🟊 ハードウェア加速に対応しており、最大8Kクラスの画像処理もスムーズに行える高速性能;

- 🟊 最大1000枚までの一括処理に対応し、大量の画像を扱う場面でも作業効率を大きく高められる;

- 🟊 アップスケーリング以外、顔レタッチ、色補正、消しゴム等便利な機能も備える;

- 🟊 画像データは暗号化された環境で管理されるため、プライバシー面も安心して利用できる;

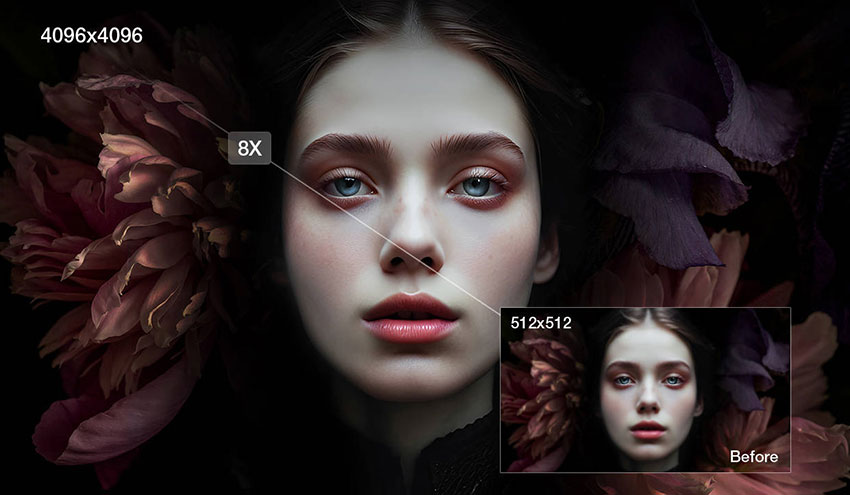

Aiarty Image Enhancerは画質が損なわれた低解像度の画像を、最大4倍または8K相当の高画質に変換できます。

さらに、AIイラスト特有の線の甘さやディテール不足を補いながら、過度なシャープ化を行わず、自然な仕上がりを実現できるのが強みです。そのため、Stable Diffusionの画質が悪い画像の高画質化処理を得意としています。

※ Aiarty Image Enhancerは、すべての機能を無料で使えますが、フルバージョンをアンロックすることで数え切れないほどの利点が得られます。

| 料金プラン | 価格 | 特徴 |

|---|---|---|

| フリー | 0円 | クレジットカードの登録不要; すべての機能を無料体験; 画像を10枚処理可能; 透かしあり書き出し可能。 |

| 年間プラン | 5,980円(税込)/ 3ユーザー | 年間で無制限画像処理; 1回につき無制限書き出し可能; AIモデル・ソフト本体の年間更新。 |

| 永久ライセンス | 7,880円(税込)/ 3ユーザー | 永久に無制限画像処理; 1回につき無制限書き出し可能; AIモデル・ソフト本体の永久更新; 生涯までのハードウェアとAPICの最適化。 |

- 【Stable Diffusionで生成した画像の画質を上げる方法】

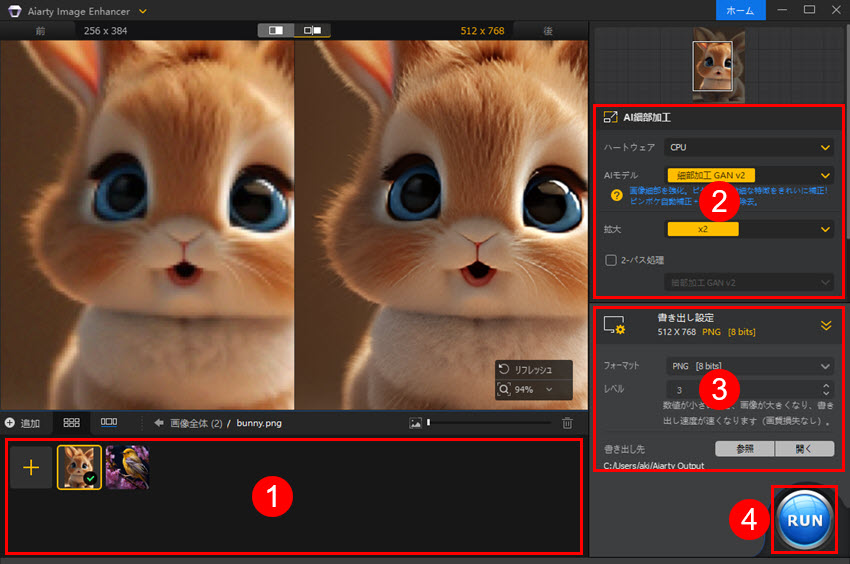

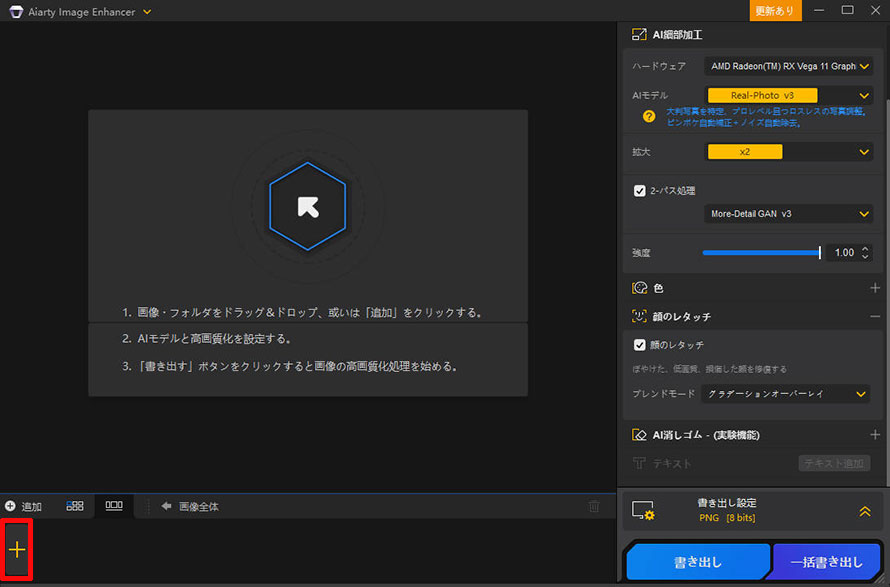

- ソフトを起動すると、このような画面になります。

- 「+」をクリックして、Stable Diffusionで生成した画像を選択してソフトに追加します。

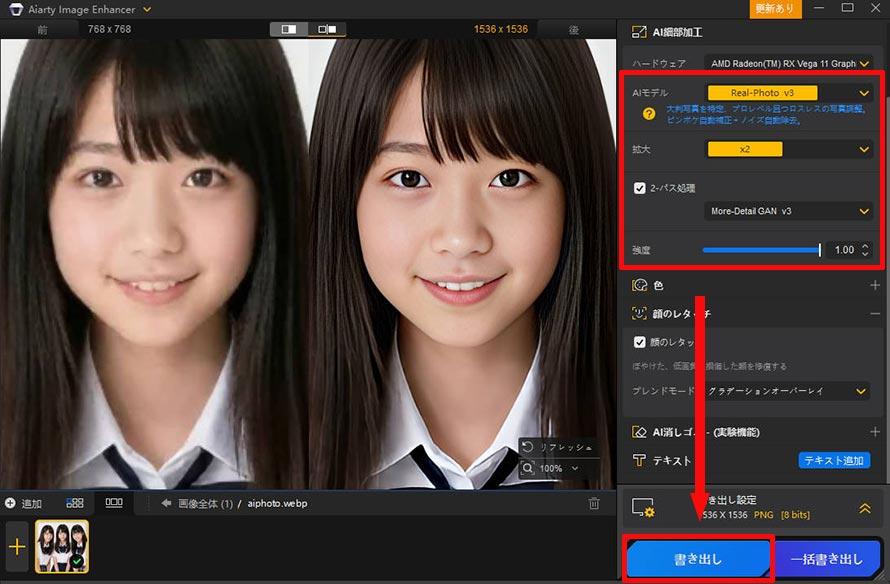

- そして、画像の種類に合ったAIモデル(例:詳細を強化したい場合は「More-Detail GAN v3」)を選択します。

- 「拡大」で、画像を何倍(2倍、4倍、8倍)に拡大するか、あるいはどの解像度(1K、2K、4K、8Kなど)までアップスケールするかを設定します。

- プレビューでは、効果(高画質化前/左と高画質化後/右))を確認した後、「書き出し」を押します。

- これで、「ぼやけを除く ⇒ ノイズを除去 ⇒ 圧縮による劣化を低減 ⇒ アップスケール」っていう順番に自動作業して、高画質化を実現することができます。

2. 標準や拡張機能を使う(Hires.fix / MultiDiffusion / Tiled Diffusionなど)

Stable Diffusionで生成した画像の画質が悪いと感じた場合、標準機能や拡張機能で高解像度化・高画質化の画像を再度生成することができます。

このような機能は、以下3つのものがあげられます。

- ➊.Hires.fix

- ➋.MultiDiffusion

- ➌.Tiled Diffusion

- Hires.fix

- 構図の破綻を抑えつつ高解像度の画像を生成するためのオプション機能です。Stable Diffusionは元々256 x 256や512 x 512などの画像でしか学習されていないので、それ以上のサイズで生成しようとすると、構図の破綻や画質の劣化が起きることがあります。

- MultiDiffusion

- 低VRAM容量でも高解像度の画像を生成できる、img2imgで使用可能な拡張機能です。img2imgで画像生成する際にも使用できるアップスケーラで、元の画像の構図やタッチを保ったまま画像サイズを拡大、高精細化することができます。個人的には一番綺麗にアップスケールができて使いやすく好き。

- Tiled Diffusion

- 少ないVRAM容量でもイラストを高解像度化・高画質化にアップスケールできる拡張機能です。画像全体のサイズを1度に大きくするのではなく、タイルのように分割して1枚1枚高解像度化・高画質化することで、VRAM使用量を減らすことができるのが大きな魅力です。

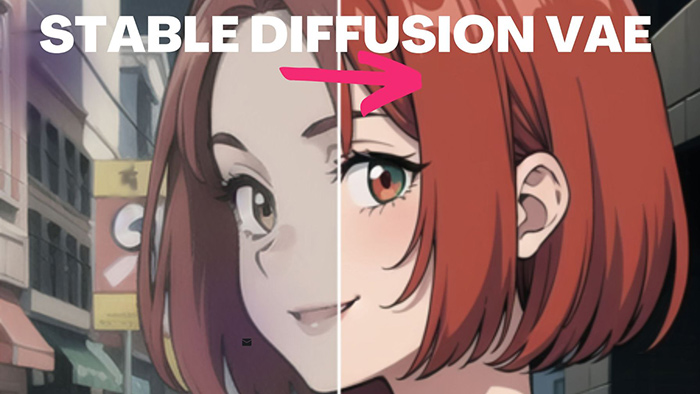

3. VAEを使用する

Stable Diffusionの「VAE(ブイエーイー)」とはVariational Auto-Encoderの略で、画像生成モデルに属する補助ツールの一種です。

Stable DiffusionにVAEを導入すると、画像をより鮮明にする効果があります。これもStable Diffusionで生成した画像の画質が悪いときの対処法の一種です。

具体的に、「VAE」を使うことで、色褪せた感じ・暗い感じや全体的にぼやけた印象が改善され、彩度などが明るくなり高品質に仕上げることができます。同じプロンプトでも、使わなかった場合と比べるとクオリティが劇的に変わるので必須で使用した方がいいです。

下記画像をご覧ください。VAEなしで生成した画像は全体にモヤがかかっているのに対して、VAEありで生成した画像は全体がハッキリしているのが分かると思います。

VAE は、CivitAIやHugging Faceのサイトからダウンロードして導入すると使用することが出来ます。

4. LoRAモデルを使用する

Stable Diffusionで利用するLoRAとは、Low Rank Adaptationの略称で、Stable Diffusionでcheckpointと呼ばれるモデルファイルに対して追加学習を行い、差分を記録したファイルを意味します。

いわば、元のモデルファイルに対して微調整を行う機能で、服装や人物、背景などのデティールを正確に表現をできます。

従来の追加学習では計算量が多いために高スペックなパソコンが必要でしたが、Loraの登場により、手軽に追加学習できるようになりました。

LoRAを活用することで、元のモデルでは表現できなかった繊細な画風やスタイルが表現できるようになります。

例えば、布の質感や光の反射の表現が自然になったり、ある有名な画家のスタイルを模倣した画像を作ることができたりします。

しかも、これまでにない速さで、オリジナリティあふれた高品質作品を低コストで大量に生み出すことができます。Stable Diffusionで生成した画像の画質が悪くなった場合、LoRAの活用を忘れないてください。

5. プロンプトを上手に作る

Stable Diffusionには、細かなカスタムオプションが搭載されていますが、画像生成の大部分が「プロンプト」に依存しています。

適切なプロンプトが与えられることで、生成される画像の方向性や詳細に関する情報がモデルに正確に伝わり、生成される画像の品質が向上する可能性があります。

また、ぼやけさせないための対処法として品質、解像度に関わる呪文をプロンプトに入れる方法があります。

以下の呪文では高品質にさせてくれる効果があり、ぼやけにくくなったりする場合があるので、Stable Diffusionで生成した画像の画質が悪いと感じたら、追加して試してみてください。

- ・masterpiece

- ・best quality

- ・ultra-detailed

- ・8k

- ・high resolution

ネガティブプロンプトにも品質や解像度に関する呪文を入れることでさらに改善が見込めます。

以下の呪文では、低品質な画像生成を省く効果があるので是非入れてみてください。

- ・worst quality

- ・low quality

- ・normal quality

- ・lowres

- ・blurry

6. Restore facesにチェックを入れる

Stable Diffusionでは、人間の顔の微細なディテールを完全に捉えることが出来ないことがあり、ゆがんだりすることがあります。人物を描くと顔が崩れがちです。

だから、Stable Diffusionで生成した人の画像がおかしいという場合は、それを抑えるための機能「 Restore faces 」にチェックを入れるだけで問題が解消されることがあります。

Restore facesは、画像の顔の歪みや不自然な部分を修正するための機能です。

ただ、学習モデルによっては、機能が正しく動作しないことがあるようです。例えば、全身像のような引きの絵で顔が小さめでぐずぐずに壊れている場合は補正が効きません。

また、イラスト系の画像生成では逆効果になってしまうこともあり、実写系の画像生成のみに使える機能となっています。

7. 他のパラメータの調整

Stable diffusionの画質が悪い、生成した画像がぼやけると感じた場合は、Stable Diffusionが提供する各パラメータを適切に調整することで、美しい高品質な画像を生成することが可能です。

ここでは、「Denoising strength」の設定を例にして説明します。

Denoising strengthというのは、Stable Diffusionのimg2imgで静止画を生成する際に、元画像からの変化度合いを設定する数値です。基本的に、数値が小さいほど元画像に忠実に、大きいほど元画像とは異なる画像を生成します。

- ハイレゾ時に、

- 上げると描画精度が上がるが、代わりに奇形が生まれやすいです。

- 下げると奇形は減って安定するけど、輪郭線がボケるなど画質は落ちます。

- 推奨は0.3〜0.6

- 0.7以上にするとだいたい奇形になります。

他に、Seed、サンプラー、Step数、CFG値、embeddings、RoHA、AddNetx2026; x2026;など様々なパラメータも利用可能です。

これらのパラメータは、生成される画像の特定の側面や性質を制御するために重要です。

たとえば、Seedはランダム性を操作し、同じ条件下での画像生成の再現性を確保します。

サンプラーは、生成される画像の色彩や構造などの特徴を調整します。

Step数は、生成プロセスの収束速度や生成される画像の鮮明度に影響を与えます。

CFG値やembeddingsは、生成される画像の内容やコンテキストを指定します。

RoHAやAddNetは、生成される画像の表現能力や詳細さを制御します。

これらのパラメータを適切に調整することで、特定の目的や要件に合った高品質な画像を生成することが可能となります。

(3)まとめ

以上でStable Diffusionの画質が悪い時の対処法について解説しました。

一番効果の高くて簡単なのは、「Aiarty Image Enhancer」という専門のAIアップスケールツールを使うとはっきりと写るようになってくるのでおすすめの方法になっています。

-

【期間限定】Aiartyの大感謝セール開催中! - 最大67%OFF

【期間限定】Aiartyの大感謝セール開催中! - 最大67%OFF最新AIモデル搭載、専門知識不要、AI高画質化・鮮明化・ロスレス拡大ソフト。

原価:23,000円セール価格:7,880円(永久版3台|税込み)

さらに、画像を生成する際に、画質劣化や低品質を抑えるために、高解像度化・高画質化を目指す標準や拡張機能を利用したり、VAEやLoRAモデルを活用したりすることが重要です。また、適切なプロンプトを使用したり、各パラメータを調整したりすることも効果的です。

これらの方法を組み合わせることで、Stable Diffusionを用いて高品質な画像を生成することが可能となります。

この記事を書いた人:小林浅

好きな仕事を追い求めるうちにweb業界へと流れ着く。AI(人工知能)に関する技術や、製品・サービスなどの紹介記事を提供しています。